深入淺析RabbitMQ鏡像集群原理

集群架構

RabbitMQ 集群是一個或多個節點的邏輯分組,集群中的每個節點都是對等的

每個節點共享所有的用戶,虛擬主機,隊列,交換器,綁定關系,運行時參數和其他分佈式狀態等信息。

一個高可用,負載均衡的 RabbitMQ 集群架構應類似下圖:

這裡對上面的集群架構做一下解釋說明:

1)首先一個基本的 RabbitMQ 集群不是高可用的

雖然集群共享隊列,但在默認情況下,消息隻會被路由到某一個節點的符合條件的隊列上,並不會同步到其他節點的相同隊列上。

假設消息路由到 node1 的 my-queue 隊列上,但是 node1 突然宕機瞭,那麼消息就會丟失

想要解決這個問題,需要開啟隊列鏡像,將集群中的隊列彼此之間進行鏡像,此時消息就會被拷貝到處於同一個鏡像分組中的所有隊列上。

2)其次 RabbitMQ 集群本身並沒有提供負載均衡的功能

也就是說對於一個三節點的集群,每個節點的負載可能都是不相同的,想要解決這個問題可以通過硬件負載均衡或者軟件負載均衡的方式

這裡我們選擇使用 HAProxy 來進行負載均衡,當然也可以使用其他負載均衡中間件,如LVS等。

HAProxy 同時支持四層和七層負載均衡,並基於單一進程的事件驅動模型,因此它可以支持非常高的井發連接數。

3)接著假設我們隻采用一臺 HAProxy

那麼它就存在明顯的單點故障的問題

所以至少需要兩臺 HAProxy ,同時這兩臺 HAProxy 之間需要能夠自動進行故障轉移,通常的解決方案就是 KeepAlived 。

KeepAlived 采用 VRRP (Virtual Router Redundancy Protocol,虛擬路由冗餘協議) 來解決單點失效的問題

它通常由一組一備兩個節點組成,同一時間內隻有主節點會提供對外服務,並同時提供一個虛擬的 IP 地址 (Virtual Internet Protocol Address ,簡稱 VIP) 。

如果主節點故障,那麼備份節點會自動接管 VIP 並成為新的主節點 ,直到原有的主節點恢復。

4)最後,任何想要連接到 RabbitMQ 集群的客戶端

隻需要連接到虛擬 IP,而不必關心集群是何種架構。

搭建集群準備:

1、準備3個虛擬機

vi /etc/hostname #修改虛擬機名稱 node1 node2 node3

| 虛擬機(機器)名稱 | node1 | node2 | node3 |

|---|---|---|---|

| ip | 192.168.0.101 | 192.168.0.102 | 192.168.0.103 |

| 安裝 | Erlang+RabbitMQ | Erlang+RabbitMQ | Erlang+RabbitMQ |

2、設置node1、node2、node3的hosts

vi /etc/hosts #修改虛擬機hosts node1 node2 node3

文件內容:

192.168.0.101 node1 192.168.0.102 node2 192.168.0.103 node3

安裝Erlang:

由於RabbitMQ是基於Erlang(面向高並發的語言)語言開發,所以在安裝RabbitMQ之前,需要先安裝Erlang。

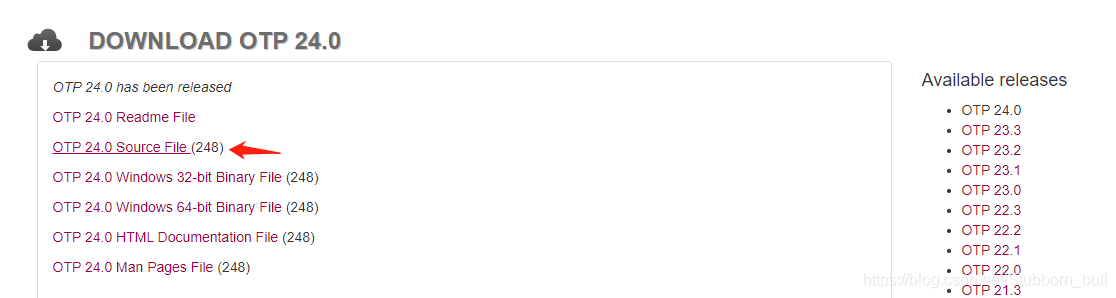

1.選擇Erlang和RabbitMQ版本,這裡選擇RabbitMQ3.9.x、Erlang24.0,查看對應版本

2.Erlang官網下載、Github下載

3.更新基本系統,安裝任何軟件包之前,建議使用以下命令更新軟件包和存儲庫

yum -y update

4、安裝 tar

yum install -y tar

5、首先要先安裝GCC、 GCC-C++、 Openssl等依賴模塊:

yum -y install make gcc gcc-c++ kernel-devel m4 ncurses-devel openssl-devel

6、再安裝ncurses模塊

yum -y install ncurses-devel yum install ncurses-devel

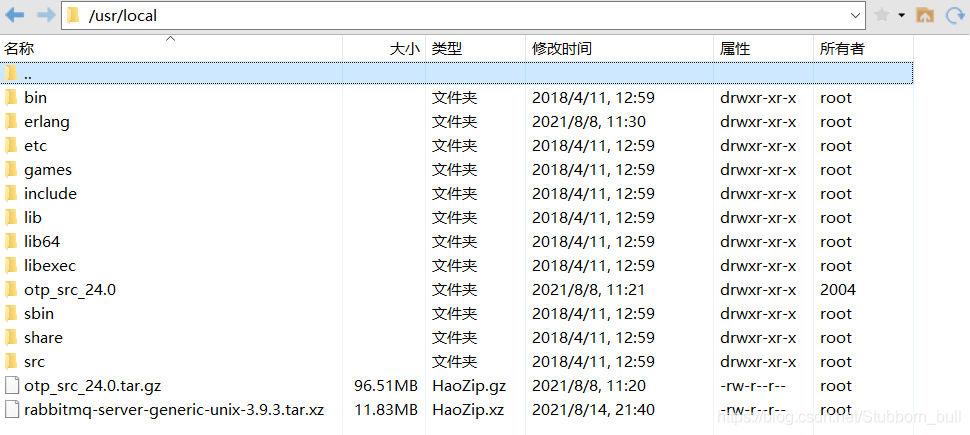

7、將安裝包拷貝到linux下:

8、解壓ErLang安裝包

[root@node1 /]# cd /usr/local/ #先切換到安裝包目錄 [root@nodel local]# ls #查看文件 bin etc games include lib lib64 libexec otp_src_24.0 otp_src_24.0.tar.gz sbin share src [root@nodel local]# tar -xvf otp_src_24.0.tar.gz #解壓文件

9、創建安裝的目錄/usr/local/erlang

[root@node1 local]# mkdir erlang [root@node1 local]# ls bin erlang etc games include lib lib64 libexec otp_src_24.0 otp_src_24.0.tar.gz sbin share src [root@node1 local]#

10、切換到解壓後的目錄

[root@node1 local]# cd otp_src_24.0 [root@node1 otp_src_24.0]# ls AUTHORS bootstrap configure.src erl-build-tool-vars.sh HOWTO LICENSE.txt Makefile.in otp_patch_apply otp_versions.table prebuilt.files system xcomp bin configure CONTRIBUTING.md erts lib make otp_build OTP_VERSION plt README.md TAR.include [root@node1 otp_src_24.0]#

11、配置安裝路徑

./configure --prefix=/usr/local/erlang --with-ssl --enable-threads --enable-smp-support --enable-kernel-poll --enable-hipe --without-javac

erlang的編譯需要用到java環境,如果不裝,會報錯如下,但不影響後續操作

12、進行編譯安裝

make && make install

13、查看安裝

[root@node1 local]# cd erlang/ [root@node1 erlang]# ll total 4 drwxr-xr-x. 2 root root 4096 Aug 7 23:30 bin drwxr-xr-x. 3 root root 19 Aug 7 23:30 lib [root@node1 erlang]#

14、配置環境變量

vi /etc/profile

加入一下配置:

######### erlang ############# PATH=$PATH:/usr/local/erlang/bin ########################################

15、使配置生效:

source /etc/profile

16、直接輸入 erl 、得到如下圖得安裝成功,輸入 halt(). 退出

安裝RabbitMQ:

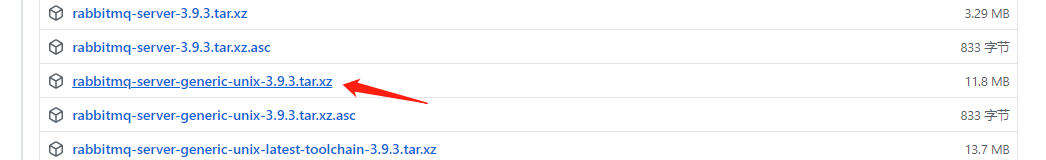

1、Github下載

2、將安裝包拷貝到linux下:

3、解壓到 /usr/local/ 目錄下

[root@node1 local]# tar -xvf rabbitmq-server-generic-unix-3.9.3.tar.xz ****** [root@node1 local]# ls bin etc include lib64 otp_src_24.0 rabbitmq_server-3.9.3 sbin src erlang games lib libexec otp_src_24.0.tar.gz rabbitmq-server-generic-unix-3.9.3.tar.xz share

4、添加環境變量

vi /etc/profile

加入一下配置:

######### RabbitMQ ############# PATH=$PATH:/usr/local/rabbitmq_server-3.9.3/sbin ########################################

5、使配置生效:

source /etc/profile

6、切換到解壓後的目錄

[root@node1 local]# cd rabbitmq_server-3.9.3/ [root@node1 rabbitmq_server-3.9.3]# ls escript LICENSE-APACHE2-excanvas LICENSE-erlcloud LICENSE-MIT-Erlware-Commons LICENSE-MIT-Sammy LICENSE-rabbitmq_aws etc LICENSE-APACHE2-ExplorerCanvas LICENSE-httpc_aws LICENSE-MIT-Flot LICENSE-MIT-Sammy060 plugins INSTALL LICENSE-APL2-Stomp-Websocket LICENSE-ISC-cowboy LICENSE-MIT-jQuery LICENSE-MPL sbin LICENSE LICENSE-BSD-base64js LICENSE-MIT-EJS LICENSE-MIT-jQuery164 LICENSE-MPL2 share LICENSE-APACHE2 LICENSE-BSD-recon LICENSE-MIT-EJS10 LICENSE-MIT-Mochi LICENSE-MPL-RabbitMQ [root@node1 rabbitmq_server-3.9.3]# cd sbin/ [root@node1 sbin]# ls rabbitmqctl rabbitmq-defaults rabbitmq-diagnostics rabbitmq-env rabbitmq-plugins rabbitmq-queues rabbitmq-server rabbitmq-streams rabbitmq-upgrade [root@node1 sbin]#

7、啟動web管理插件

[root@node1 sbin]# rabbitmq-plugins enable rabbitmq_management Enabling plugins on node rabbit@localhost: rabbitmq_management The following plugins have been configured: rabbitmq_management rabbitmq_management_agent rabbitmq_web_dispatch Applying plugin configuration to rabbit@localhost... The following plugins have been enabled: rabbitmq_management rabbitmq_management_agent rabbitmq_web_dispatch started 3 plugins.

8、後臺啟動rabbitmq服務

rabbitmq-server -detached

9、啟用瞭rabbitmq的管理插件,會有一個web管理界面,默認監聽端口15672,將此端口在防火墻上打開,則可以訪問web界面:

使用默認的用戶 guest / guest (此也為管理員用戶)登陸,會發現無法登陸,

報錯:User can only log in via localhost。

那是因為默認是限制瞭guest用戶隻能在本機登陸,也就是隻能登陸localhost:15672。

可以通過修改配置文件rabbitmq.conf,取消這個限制: loopback_users這個項就是控制訪問的,

如果隻是取消guest用戶的話,隻需要loopback_users.guest = false 即可。或者添加遠程用戶

10、添加遠程用戶

# 添加用戶 rabbitmqctl add_user 用戶名 密碼 # 設置用戶角色,分配操作權限 rabbitmqctl set_user_tags 用戶名 角色 # 為用戶添加資源權限(授予訪問虛擬機根節點的所有權限) rabbitmqctl set_permissions -p / 用戶名 ".*" ".*" ".*"

角色有四種:

- administrator:可以登錄控制臺、查看所有信息、並對rabbitmq進行管理

- monToring:監控者;登錄控制臺,查看所有信息

- policymaker:策略制定者;登錄控制臺指定策略

- managment:普通管理員;登錄控制

這裡創建用戶rabbitadmin,密碼rabbitadmin,設置administrator角色,賦予所有權限

[root@node1 sbin]# rabbitmqctl add_user rabbitadmin rabbitadmin Adding user "rabbitadmin" ... Done. Don't forget to grant the user permissions to some virtual hosts! See 'rabbitmqctl help set_permissions' to learn more. [root@node1 sbin]# rabbitmqctl set_user_tags rabbitadmin administrator Setting tags for user "rabbitadmin" to [administrator] ... [root@node1 sbin]# rabbitmqctl set_permissions -p / rabbitadmin ".*" ".*" ".*" Setting permissions for user "rabbitadmin" in vhost "/" ... [root@node1 sbin]#

11、登錄,其他兩臺虛擬機也是如上配置

同步cookie:

1、如何查看cookie

[root@node1 rabbitmq]# pwd /usr/local/rabbitmq_server-3.9.3/var/log/rabbitmq [root@node1 rabbitmq]# more rabbit\@node1.log ****** 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> node : rabbit@node1 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> home dir : /root 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> config file(s) : (none) 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> cookie hash : baCpCWaCXrmkyZweJiNbVw== 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> log(s) : /usr/local/rabbitmq_server-3.9.3/var/log/rabbitmq/rabbit@node1.log 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> : /usr/local/rabbitmq_server-3.9.3/var/log/rabbitmq/rabbit@node1_upgrade.log 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> : <stdout> 2021-08-14 21:11:06.883853-04:00 [info] <0.222.0> database dir : /usr/local/rabbitmq_server-3.9.3/var/lib/rabbitmq/mnesia/rabbit@node1

我的${home}目錄是/root,切換到root目錄下,該文件是一個隱藏文件,需要使用 ls -al 命令查看

[root@node1 ~]# pwd /root [root@node1 ~]# ls -la total 52 dr-xr-x---. 2 root root 4096 Aug 14 21:10 . dr-xr-xr-x. 18 root root 4096 Nov 12 2020 .. -rw-------. 1 root root 993 Nov 7 2020 anaconda-ks.cfg -rw-------. 1 root root 14288 Aug 14 23:07 .bash_history -rw-r--r--. 1 root root 18 Dec 28 2013 .bash_logout -rw-r--r--. 1 root root 176 Dec 28 2013 .bash_profile -rw-r--r--. 1 root root 176 Dec 28 2013 .bashrc -rw-r--r--. 1 root root 100 Dec 28 2013 .cshrc -r--------. 1 root root 20 Aug 14 00:00 .erlang.cookie -rw-r--r--. 1 root root 129 Dec 28 2013 .tcshrc [root@node1 ~]#

2、同步(拷貝.cookie時,各節點都必須停止MQ服務,在node1上執行遠程操作命令)

scp /root/.erlang.cookie root@node2:/root/ scp /root/.erlang.cookie root@node3:/root/

集群搭建:

1、啟動RabbitMQ服務,順帶啟動Erlang虛擬機和RabbitMQ應用服務,在node1、node2、node3執行命令

rabbitmq-server -detached

2、RabbitMQ 集群的搭建需要選擇其中任意一個節點為基準,將其它節點逐步加入。這裡我們以 node1 為基準節點,將 node2 和 node3 加入集群。在 node2 和node3 上執行以下命令:

# 1.停止服務 rabbitmqctl stop_app # rabbitmqctl stop會將Erlang虛擬機關閉,rabbitmqctl stop_app隻關閉RabbitMQ服務 # 2.重置狀態 rabbitmqctl reset # 3.節點加入, 在一個node加入cluster之前,必須先停止該node的rabbitmq應用,即先執行stop_app # node2加入node1, node3加入node2 rabbitmqctl join_cluster rabbit@node1 # 4.啟動服務 rabbitmqctl start_app

join_cluster 命令有一個可選的參數 –ram ,該參數代表新加入的節點是內存節點,默認是磁盤節點。

如果是內存節點,則所有的隊列、交換器、綁定關系、用戶、訪問權限和 vhost 的元數據都將存儲在內存中,

如果是磁盤節點,則存儲在磁盤中。

內存節點可以有更高的性能,但其重啟後所有配置信息都會丟失,

因此RabbitMQ 要求在集群中至少有一個磁盤節點,其他節點可以是內存節點。

當內存節點離開集群時,它可以將變更通知到至少一個磁盤節點;

然後在其重啟時,再連接到磁盤節點上獲取元數據信息。

除非是將 RabbitMQ 用於 RPC 這種需要超低延遲的場景,

否則在大多數情況下,RabbitMQ 的性能都是夠用的,可以采用默認的磁盤節點的形式。

另外,如果節點以磁盤節點的形式加入,則需要先使用 reset 命令進行重置,然後才能加入現有群集,重置節點會刪除該節點上存在的所有的歷史資源和數據。

采用內存節點的形式加入時可以略過 reset 這一步,因為內存上的數據本身就不是持久化的

3、查看集群狀態

此時可以在任意節點上使用 rabbitmqctl cluster_status 命令查看集群狀態,輸出如下:

[root@node1 ~]# rabbitmqctl cluster_status Cluster status of node rabbit@node1 ... Basics Cluster name: rabbit@node1 Disk Nodes rabbit@node1 rabbit@node2 rabbit@node3 Running Nodes rabbit@node1 rabbit@node2 rabbit@node3 Versions rabbit@node1: RabbitMQ 3.9.3 on Erlang 24.0 rabbit@node2: RabbitMQ 3.9.3 on Erlang 24.0 rabbit@node3: RabbitMQ 3.9.3 on Erlang 24.0 Maintenance status Node: rabbit@node1, status: not under maintenance Node: rabbit@node2, status: not under maintenance Node: rabbit@node3, status: not under maintenance Alarms Free disk space alarm on node rabbit@node3 Network Partitions (none) Listeners Node: rabbit@node1, interface: [::], port: 25672, protocol: clustering, purpose: inter-node and CLI tool communication Node: rabbit@node1, interface: [::], port: 5672, protocol: amqp, purpose: AMQP 0-9-1 and AMQP 1.0 Node: rabbit@node1, interface: [::], port: 15672, protocol: http, purpose: HTTP API Node: rabbit@node2, interface: [::], port: 15672, protocol: http, purpose: HTTP API Node: rabbit@node2, interface: [::], port: 25672, protocol: clustering, purpose: inter-node and CLI tool communication Node: rabbit@node2, interface: [::], port: 5672, protocol: amqp, purpose: AMQP 0-9-1 and AMQP 1.0 Node: rabbit@node3, interface: [::], port: 15672, protocol: http, purpose: HTTP API Node: rabbit@node3, interface: [::], port: 25672, protocol: clustering, purpose: inter-node and CLI tool communication Node: rabbit@node3, interface: [::], port: 5672, protocol: amqp, purpose: AMQP 0-9-1 and AMQP 1.0 Feature flags Flag: drop_unroutable_metric, state: enabled Flag: empty_basic_get_metric, state: enabled Flag: implicit_default_bindings, state: enabled Flag: maintenance_mode_status, state: enabled Flag: quorum_queue, state: enabled Flag: stream_queue, state: enabled Flag: user_limits, state: enabled Flag: virtual_host_metadata, state: enabled [root@node1 ~]#

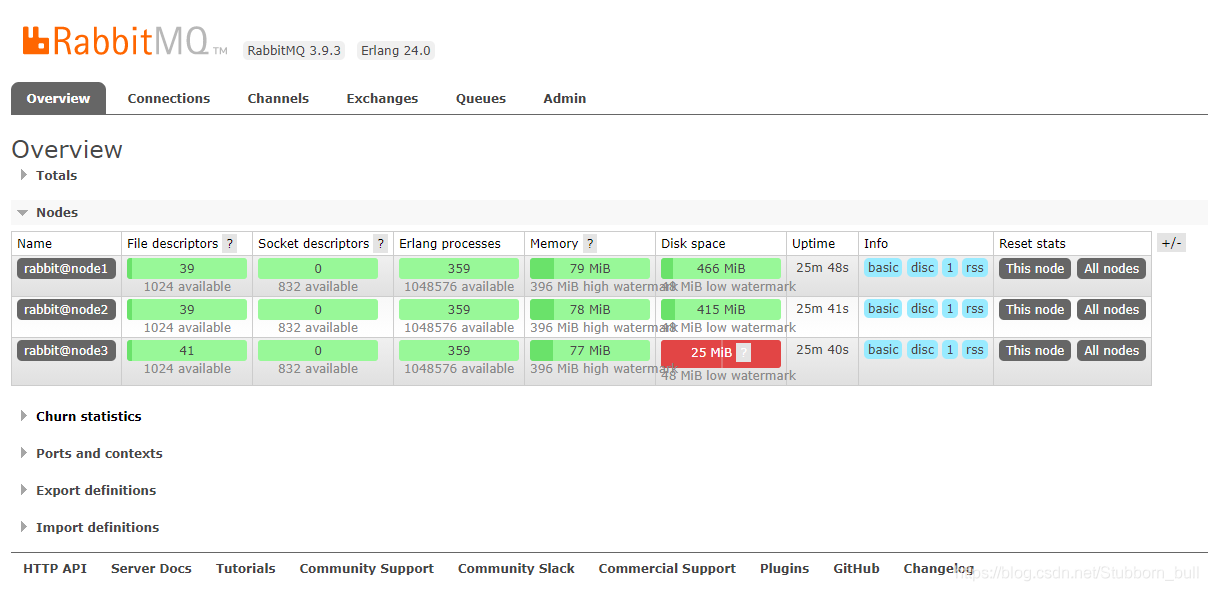

4、UI 界面查看

鏡像隊列:

1、鏡像的配置是通過 policy 策略的方式,以命令的方式設置 或 UI界面設置

2、參數說明:

- Name:policy的名稱

- Pattern: queue的匹配模式(正則表達式)

- priority:可選參數,policy的優先級

- Definition:鏡像定義,包括三個部分ha-mode、ha-params、ha-sync-mode

- ha-mode:指明鏡像隊列的模式,有效值為 all/exactly/nodes

- all:表示在集群中所有的節點上進行鏡像

- exactly:表示在指定個數的節點上進行鏡像,節點的個數由ha-params指定

- nodes:表示在指定的節點上進行鏡像,節點名稱通過ha-params指定

- ha-params:ha-mode模式需要用到的參數

- ha-sync-mode:進行隊列中消息的同步方式,有效值為automatic(自動)和manual(手動)

3、對隊列名稱以“queue_”開頭的所有隊列進行鏡像,並在集群的兩個節點上完成進行,policy的設置命令為:

[root@node1 ~]# rabbitmqctl set_policy ha-queue-two '^queue_' '{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}'

Setting policy "ha-queue-two" for pattern "^queue_" to "{"ha-mode":"exactly","ha-params":2,"ha-sync-mode":"automatic"}" with priority "0" for vhost "/" ...

[root@node1 ~]#

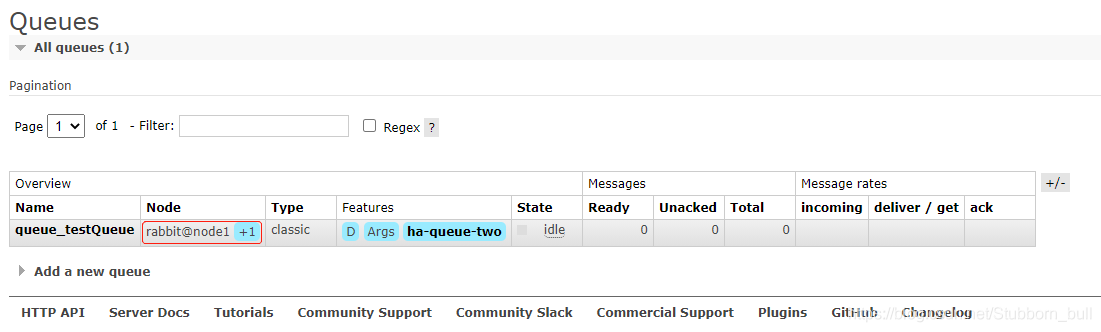

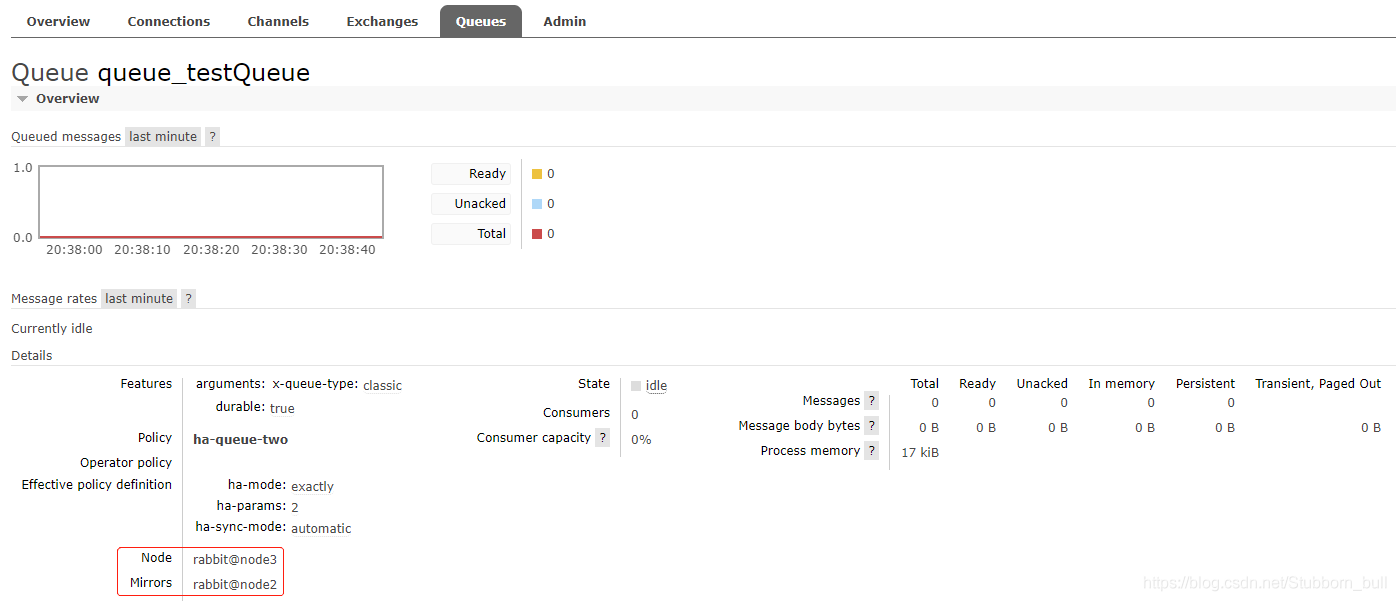

4、在任意節點(我在node1節點)創建queue_testQueue隊列,並查看鏡像狀態

上圖Node中的+1表示備份,下圖中的Mirrors就是備份的節點,若node1宕機瞭node3就會代替node1繼續提供服務

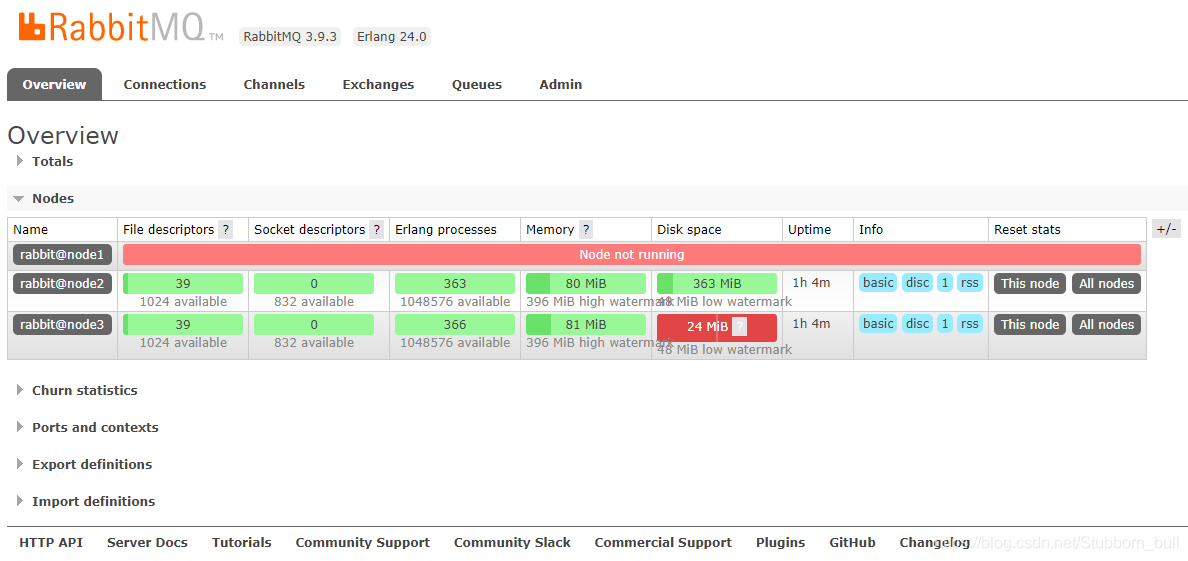

測試:首先關閉node1節點

然後查看node3節點上的鏡像狀態,發現在node2節點也進行瞭備份,以此說明:就算整個集群隻剩下一臺機器瞭,依然能消費隊列裡面的消息

5、復制系數

若ha-mode 的值為 all ,代表消息會被同步到所有節點的相同隊列中,如果你的集群有很多節點,那麼此時復制的性能開銷就比較大,此時需要選擇合適的復制系數。

通常可以遵循過半寫原則,即對於一個節點數為 n 的集群,隻需要同步到 n/2+1 個節點上即可。

6、集群的關閉與重啟

沒有一個直接的命令可以關閉整個集群,需要逐一進行關閉。但是需要保證在重啟時,最後關閉的節點最先被啟動。如果第一個啟動的不是最後關閉的節點,那麼這個節點會等待最後關閉的那個節點啟動,默認進行 10 次連接嘗試,超時時間為 30 秒,如果依然沒有等到,則該節點啟動失敗。

這帶來的一個問題是,假設在一個三節點的集群當中,關閉的順序為 node1,node2,node3,如果 node1 因為故障暫時沒法恢復,此時 node2 和 node3 就無法啟動。想要解決這個問題,可以先將 node1 節點進行剔除,命令如下:

rabbitmqctl forget_cluster_node rabbit@node1 --offline

此時需要加上 -offline 參數,它允許節點在自身沒有啟動的情況下將其他節點剔除。

7、解除集群

重置當前節點:

# 1.停止服務 rabbitmqctl stop_app # 2.重置集群狀態 rabbitmqctl reset # 3.重啟服務 rabbitmqctl start_app

重新加入集群:

# 1.停止服務 rabbitmqctl stop_app # 2.重置狀態 rabbitmqctl reset # 3.節點加入 rabbitmqctl join_cluster rabbit@node1 # 4.重啟服務 rabbitmqctl start_app

完成後重新檢查 RabbitMQ 集群狀態:

rabbitmqctl cluster_status

除瞭在當前節點重置集群外,還可在集群其他正常節點將節點踢出集群

rabbitmqctl forget_cluster_node rabbit@node3

8、變更節點類型

我們可以將節點的類型從RAM更改為Disk,反之亦然。假設我們想要反轉rabbit@node2和rabbit@node1的類型,將前者從RAM節點轉換為磁盤節點,而後者從磁盤節點轉換為RAM節點。為此,我們可以使用change_cluster_node_type命令。必須首先停止節點。

# 1.停止服務 rabbitmqctl stop_app # 2.變更類型 ram disc rabbitmqctl change_cluster_node_type disc # 3.重啟服務 rabbitmqctl start_app

9、清除 RabbitMQ 節點配置

# 如果遇到不能正常退出直接kill進程 systemctl stop rabbitmq-server # 查看進程 ps aux|grep rabbitmq # 清除節點rabbitmq配置 rm -rf /var/lib/rabbitmq/mnesia

到此這篇關於深入淺析RabbitMQ鏡像集群原理的文章就介紹到這瞭,更多相關RabbitMQ鏡像集群內容請搜索WalkonNet以前的文章或繼續瀏覽下面的相關文章希望大傢以後多多支持WalkonNet!

推薦閱讀:

- Linux RabbitMQ 集群搭建流程圖解

- Docker搭建RabbitMq的普通集群和鏡像集群的詳細操作

- 運用.net core中實例講解RabbitMQ高可用集群構建

- RabbitMQ的Web管理與監控簡介

- Docker部署rabbitmq遇到的兩個問題