基於pycharm的beautifulsoup4庫使用方法教程

1.beautifulsoup4庫安裝

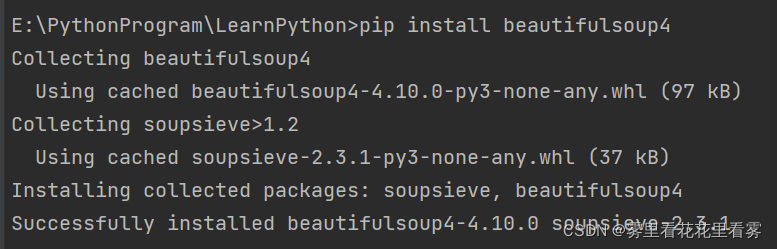

第一步:在控制臺輸入如下命令,安裝beautifulsoup4庫。

pip install beautifulsoup4

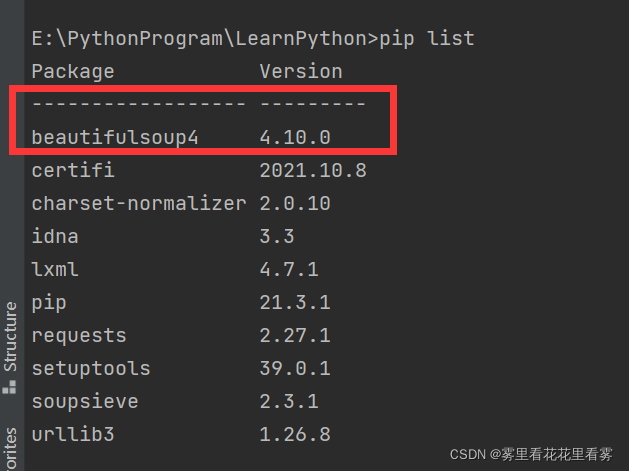

第二步:在控制臺輸入如下命令,驗證是否成功安裝beautifulsoup4庫。

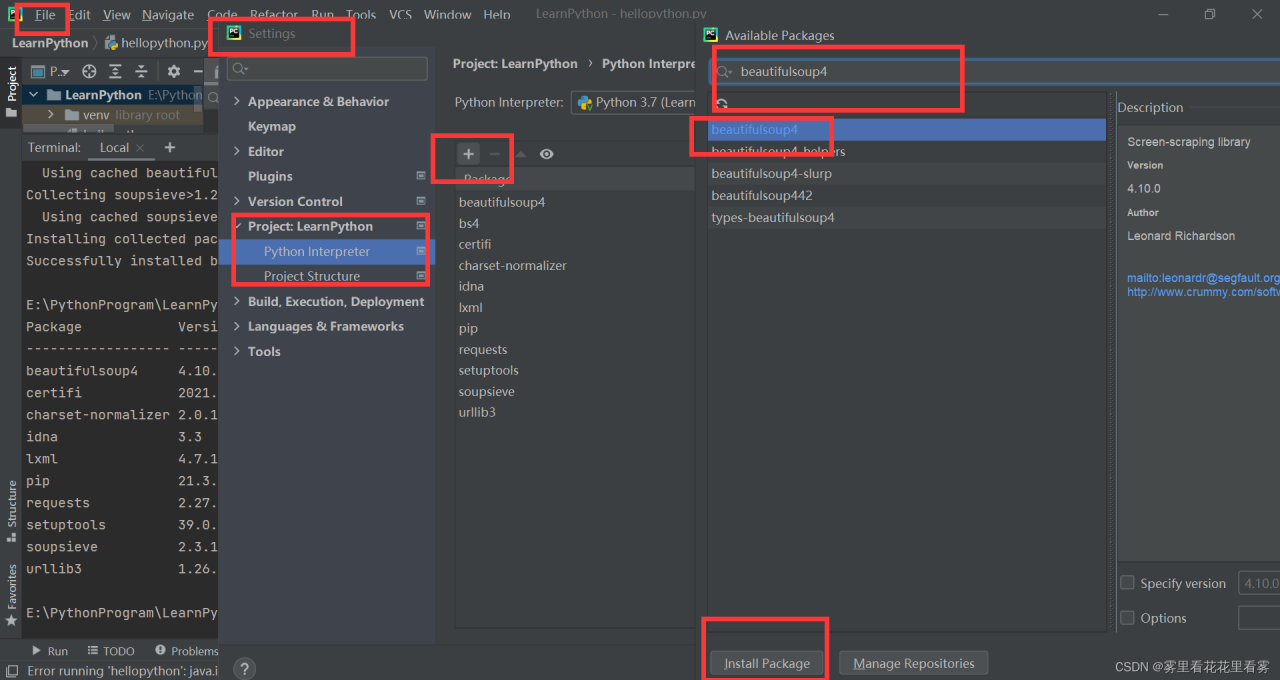

第三步:在pycharm中,點擊file——settings——project——python interpreter——點擊+號——搜索beautifulsoup4——install package!

這樣就可以在.py文件中導入模塊瞭!

2.beautifulsoup4庫使用

import requests

# 雖然庫名叫做beautiful4 但是在導入時 使用的是其縮寫bs4 其中BeautifulSoup是一個類名

from bs4 import BeautifulSoup

url = 'https://www.baidu.com/s?'

# 由於一般網站都是供用戶訪問 如果檢測到User-Agent是黑客或者其他可能拒絕訪問 故此處模擬瀏覽器

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/97.0.4692.71 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

# 以防亂碼 此處將其編碼設置為utf-8 因為有中文

response.encoding = 'utf-8'

# print(response.text)

# 使用的解析器是html.parser 註意是.奧

soup = BeautifulSoup(response.text, 'html.parser')

# 打印解析後的結果

print(soup.prettify())

需要講解的都在代碼註釋中瞭奧!

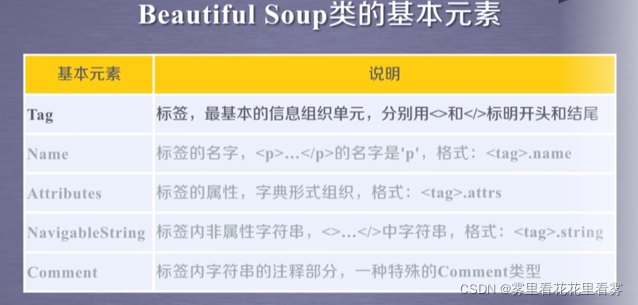

3.beautifulsoup4庫基本元素

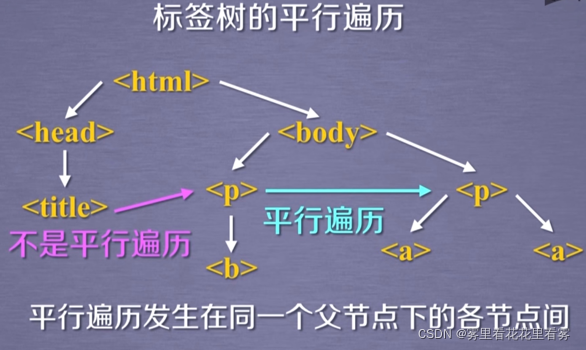

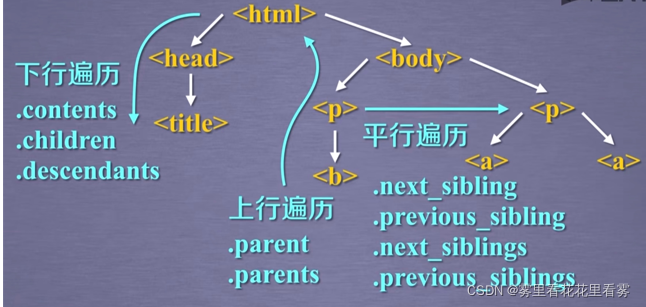

beautifulsoup4庫是解析、遍歷、維護“標簽樹”的功能庫。

首先來看BeautifulSoup庫解析器,前兩個比較常用!

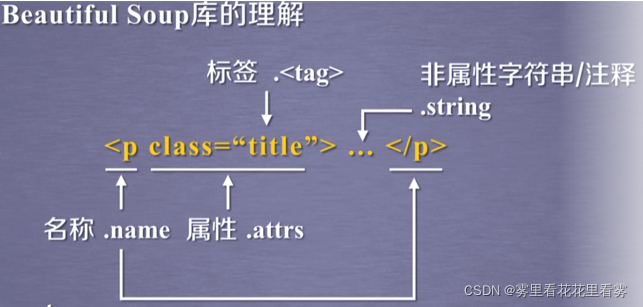

再來看BeautifulSoup庫的基本元素,可以這樣理解,標簽樹和HTML以及BeautifulSoup是一樣的,我們要看HTML的某些內容就使用BeautifulSoup的實例化對象查看即可。

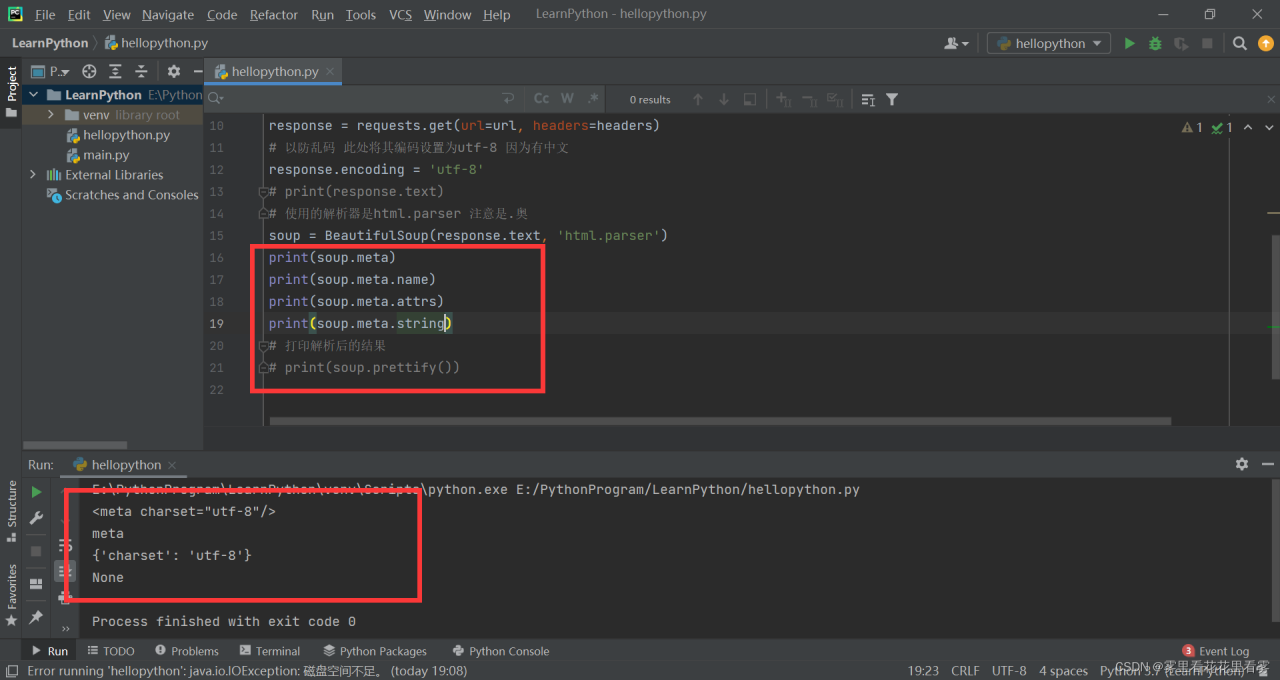

在上述代碼的基礎上,增加如下幾行,結合基本元素的使用,可得到如圖所示。

需要註意的是,.string可以跨標簽,所以很有可能結果也為註釋,為瞭區分是標簽內的字符串還是註釋,可以通過打印類型來判斷。

總結起來,可如下:

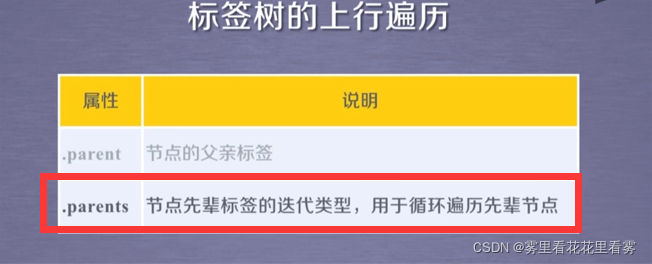

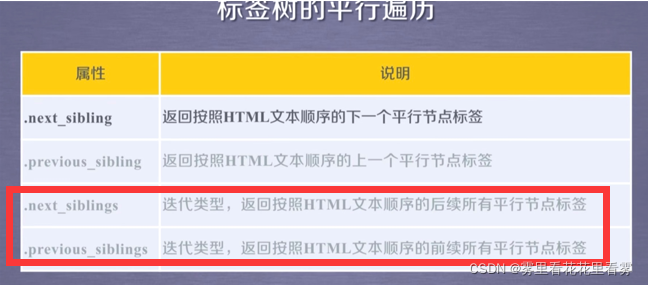

接下來,看一下BeautifulSoup庫的遍歷,其中畫紅框的迭代遍歷,可以用於for in循環中。

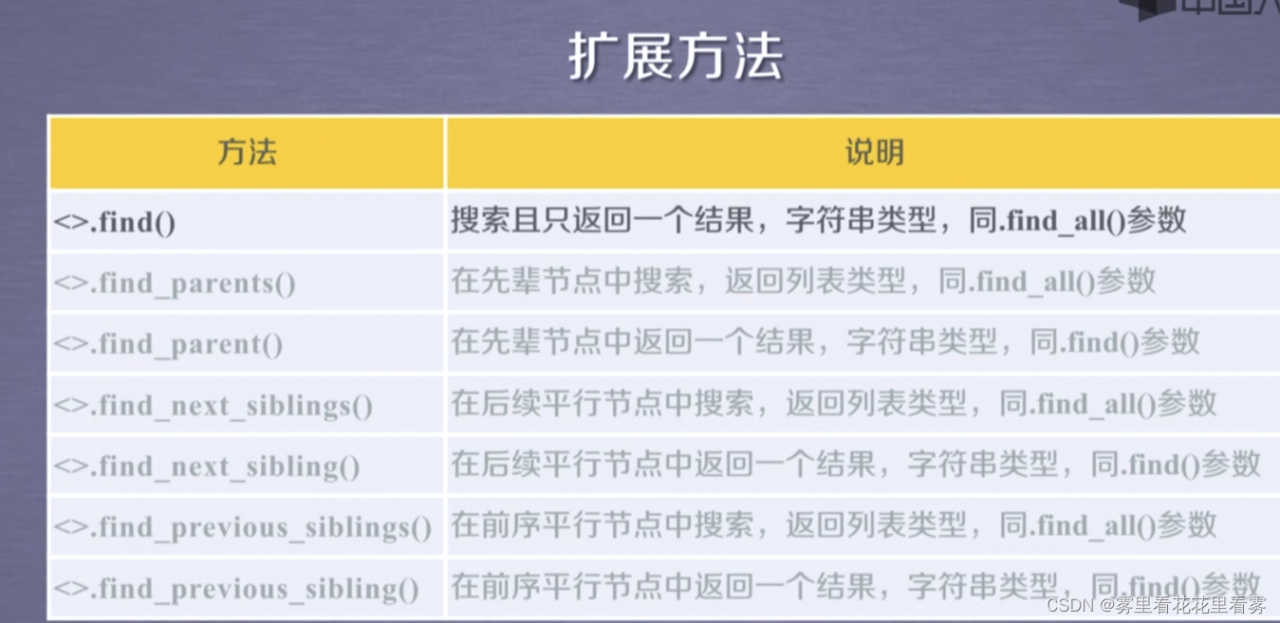

4.beautifulsoup4庫的HTML查找方法

find_all( name , attrs , recursive , string , **kwargs )

find_all() 方法搜索當前tag的所有tag子節點,並判斷是否符合過濾器的條件。

name 參數可以對名字為 name 的標簽進行檢索。

attrs參數可以對標簽屬性值為attrs的標簽進行檢索。

recursive參數表示是否對子孫全部檢索,默認是TRUE,如果隻想搜索當前節點的兒子信息,可以置其為FALSE。

string 參數可以標簽中的字符串內容進行檢索。

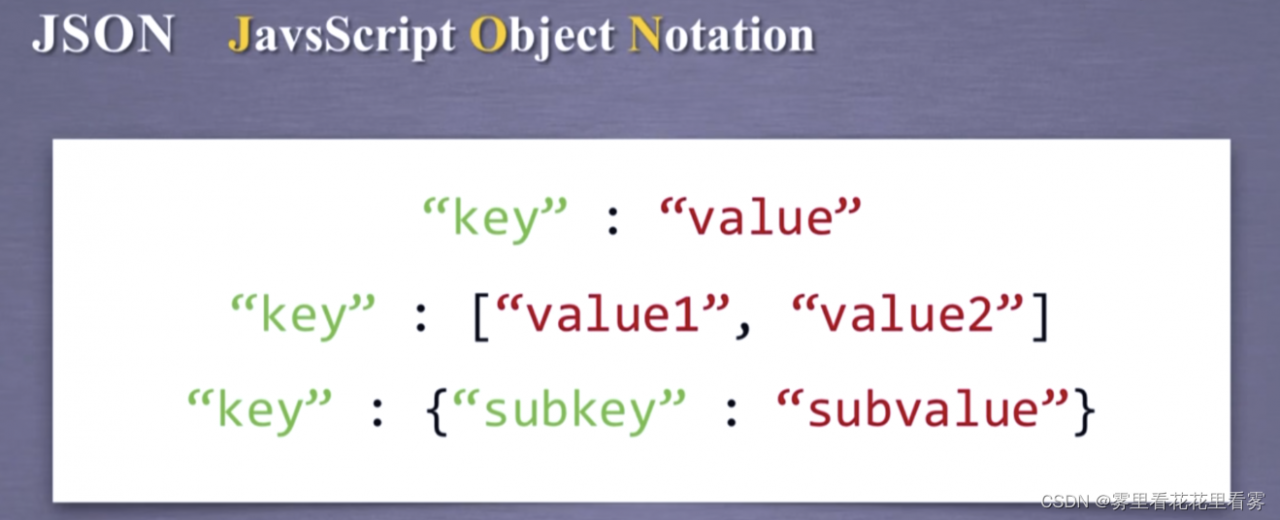

5.補充Json(Javascript Object Notation)

我們學過js的或者java的,應該對Json不陌生吧!

Json是一種有類型的鍵值對!

需要註意的是,鍵和值都需要用"“括起來,如果值是整數,則可以不用”"!

如果值是多值,則可以用[,];如果值是鍵值對,則可以用{:,:,},可以嵌套使用。

JSON一般用於接口,而YAML是無類型鍵值對,一般用於配置文件。

到此這篇關於基於pycharm的beautifulsoup4庫使用方法教程的文章就介紹到這瞭,更多相關pycharm的beautifulsoup4庫使用內容請搜索WalkonNet以前的文章或繼續瀏覽下面的相關文章希望大傢以後多多支持WalkonNet!

推薦閱讀:

- python beautifulsoup4 模塊詳情

- Python爬蟲網頁元素定位術

- python爬蟲beautifulsoup庫使用操作教程全解(python爬蟲基礎入門)

- Python爬取求職網requests庫和BeautifulSoup庫使用詳解

- Python使用Beautiful Soup實現解析網頁