Python爬蟲之批量下載喜馬拉雅音頻

一、解析網站

1.1 獲取音頻地址

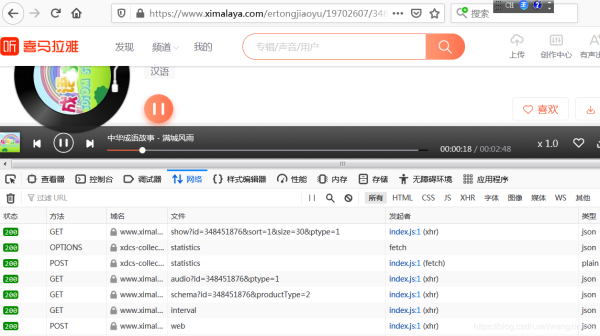

在喜馬拉雅網站上,隨便點開一個音頻,打開“開發者工具”,再點擊播放按鈕,可以看到出現瞭多個請求:

經過排查,發現可疑url:

查看它的響應信息,發現音頻地址就在裡面:

接下來,解析這個返回音頻地址的url:

https://www.ximalaya.com/revision/play/v1/audio?id=348451879&ptype=1

發現url中的id參數就決定瞭返回的音頻地址,而id參數是音頻的id號。

1.2 解析專欄網頁

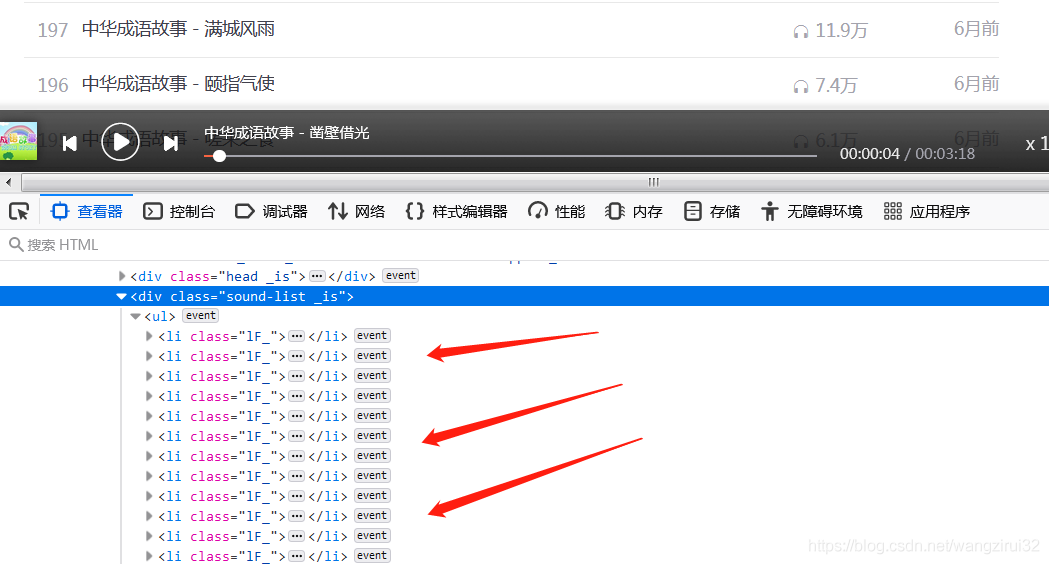

我們已經知道瞭獲取音頻url的網址,接下來要獲取一個專欄內的音頻id和名稱,打開一個專欄,發現:

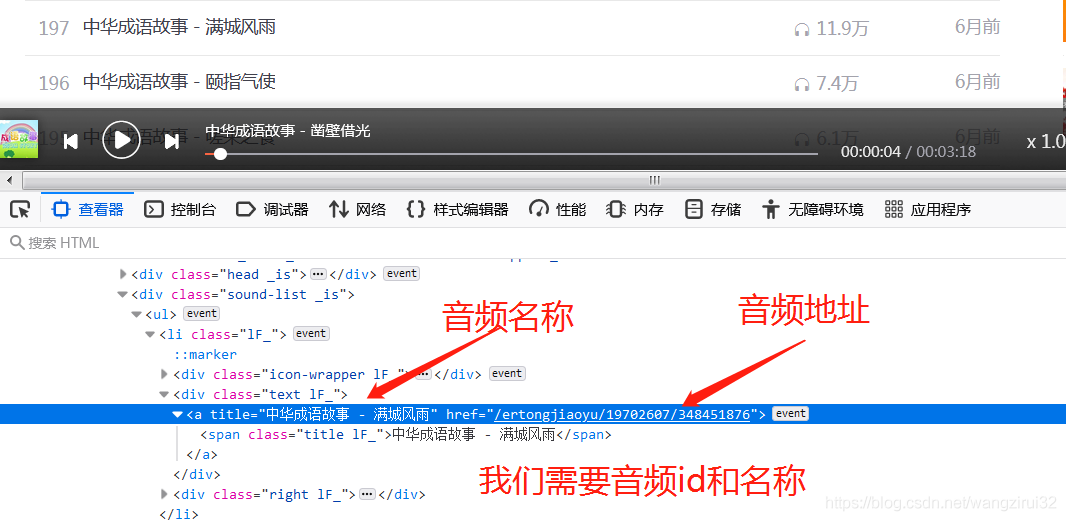

所有的音頻存放在class為1F_的li標簽中,再來解析li標簽:

在li標簽中的第一個a標簽存儲著我們所有需要的數據,妙~啊!

1.3 整理億下思路

思路:

1.獲取專欄內的li標簽

2.獲取li標簽裡的第一個a標簽

3.讀取a標簽的title和href屬性

4.將href解析成音頻id

5.將id帶入url請求音頻源地址

6.提取音頻源地址

7.請求音頻源地址

8.保存音頻(文件名為a的title屬性)

思路整理完瞭,開始編寫代碼。

二、編寫爬取代碼

代碼奉上——

import requests

from fake_useragent import UserAgent as ua

from bs4 import BeautifulSoup as bs

# 專欄地址

music_list_url = 'https://www.ximalaya.com/ertongjiaoyu/19702607/'

# 獲取音頻地址的url

get_link_url = "https://www.ximalaya.com/revision/play/v1/audio"

# UA偽裝

headers = {

"User-Agent": ua().random

}

# 參數

params = {

"id": None, # id先設為None

"ptype": "1",

}

# 獲取專欄HTML源碼

music_list_r = requests.get(music_list_url, headers=headers)

# 解析 獲取所有li標簽

soup = bs(music_list_r.text, "lxml")

li = soup.find_all("li", {"class": "lF_"})

# for循序遍歷處理

for i in li:

a = i.find("a") # 找到a標簽

# 獲取href屬性

# split("/")將字符串以"/"作為分隔符 從右往左數第一項是id號

music_id = a.get("href").split("/")[-1]

# 獲取title屬性 和“.m4a”拼接成文件名

music_name = a.get("title") + ".m4a"

# 修改請求參數id

params['id'] = music_id

# 獲得音頻源地址

r = requests.get(get_link_url, headers=headers, params=params)

link = r.json()['data']['src']

# 獲取音頻文件並保存

music_file = requests.get(link).content

with open(music_name, "wb") as f:

f.write(music_file)

print("下載完畢!")

運行代碼,等待億會(真的要等億會),可以看到當前目錄下已經出現瞭音頻文件,如圖:

到此這篇關於Python爬蟲之批量下載喜馬拉雅音頻的文章就介紹到這瞭,更多相關Python下載喜馬拉雅音頻內容請搜索WalkonNet以前的文章或繼續瀏覽下面的相關文章希望大傢以後多多支持WalkonNet!

推薦閱讀:

- 如何用Python一次性下載抖音上音樂

- Python使用Beautiful Soup實現解析網頁

- python beautifulsoup4 模塊詳情

- python爬蟲beautifulsoup庫使用操作教程全解(python爬蟲基礎入門)

- Python使用Beautiful Soup(BS4)庫解析HTML和XML