Python爬蟲之自動爬取某車之傢各車銷售數據

一、目標網頁分析

目標網站是某車之傢關於品牌汽車車型的口碑模塊相關數據,比如我們演示的案例奧迪Q5L的口碑頁面如下:

https://k.autohome.com.cn/4851/#pvareaid=3311678

為瞭演示方式,大傢可以直接打開上面這個網址,然後拖到全部口碑位置,找到我們本次采集需要的字段如下圖所示:

采集字段

我們進行翻頁發現,瀏覽器網址發生瞭變化,大傢可以對下如下幾頁的網址找出規律:

https://k.autohome.com.cn/4851/index_2.html#dataList https://k.autohome.com.cn/4851/index_3.html#dataList https://k.autohome.com.cn/4851/index_4.html#dataList

對於上面寫網址,我們發現可變部分是車型(如4851)以及頁碼(如2,3,4),於是我們可以構建url參數如下:

# typeid是車型,page是頁碼

url = f'https://k.autohome.com.cn/{typeid}/index_{page}.html#dataList'

二、數據請求

通過簡單的測試,發現似乎不存在反爬,那就簡單瞭。

我們先引入需要用到的庫:

import requests import pandas as pd import html from lxml import etree import re

然後創建一個數據請求的函數備用:

# 獲取網頁數據(傳遞參數 車型typeid和頁碼數)

def get_html(typeid,page):

# 組合出請求地址

url = f'https://k.autohome.com.cn/{typeid}/index_{page}.html#dataList'

# 請求數據(因為沒有反爬,這裡沒有設置請求頭和其他參數)

r = requests.get(url)

# 請求的網頁數據中有網頁特殊字符,通過以下方法進行解析

r = html.unescape(r.text)

# 返回網頁數據

return r

請求來的數據就是網頁html文本,我們接下來采用re解析出一共多少頁碼,再用xpath進行采集字段的解析。

三、數據解析

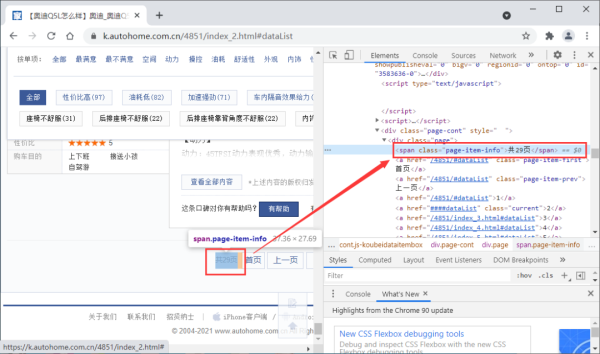

由於需要進行翻頁,這裡我們可以先通過re正則表達式獲取總頁碼。通過查看網頁數據,我們發現總頁碼可以通過如下方式獲取:

try:

pages = int(re.findall(r'共(\d+)頁',r)[0])

# 如果請求不到頁數,則表示該車型下沒有口碑數據

except :

print(f'{name} 沒有數據!')

continue

總頁碼采集

關於待采集字段信息,我們發現都在節點div[@class="mouthcon-cont-left"]裡,可以先定位這個節點數據,然後再進行逐一解析。

待采集字段信息所在節點

此外,我們發現每一頁最多15個車型口碑數據,因此我們每頁可以定位15個待采集信息數據集,遍歷采集代碼:

divs = r_html.xpath('.//div[@class="mouthcon-cont-left"]')

# 遍歷每個全部的車輛銷售信息

for div in divs:

# 找到車輛銷售信息所在的地方

mt = div.xpath('./div[@class="choose-con mt-10"]')[0]

# 找到所需字段

infos = mt.xpath('./dl[@class="choose-dl"]')

# 設置空的字典,用於存儲單個車輛信息

item = {}

# 遍歷車輛信息字段

for info in infos:

key = info.xpath('.//dt/text()')[0]

# 當字段為購買車型時,進行拆分為車型和配置

if key == '購買車型':

item[key] = info.xpath('.//dd/a/text()')[0]

item['購買配置'] = info.xpath('.//span[@class="font-arial"]/text()')[0]

# 當字段為購車經銷商時,需要獲取經銷商的id參數,再調用api獲取其真實經銷商信息(這裡有坑)

elif key == '購車經銷商':

# 經銷商id參數

經銷商id = info.xpath('.//dd/a/@data-val')[0] +','+ info.xpath('.//dd/a/@data-evalid')[0]

# 組合經銷商信息請求地址

jxs_url = base_jxs_url+經銷商id+'|'

# 請求數據(為json格式)

data = requests.get(jxs_url)

j = data.json()

# 獲取經銷商名稱

item[key] = j['result']['List'][0]['CompanySimple']

else:

# 其他字段時,替換轉義字符和空格等為空

item[key] = info.xpath('.//dd/text()')[0].replace("\r\n","").replace(' ','').replace('\xa0','')

四、數據存儲

由於沒啥反爬,這裡直接將采集到的數據轉化為pandas.DataFrame類型,然後存儲為xlsx文件即可。

df = pd.DataFrame(items) df = df[['購買車型', '購買配置', '購買地點', '購車經銷商', '購買時間', '裸車購買價']] # 數據存儲在本地 df.to_excel(r'車輛銷售信息.xlsx',index=None,sheet_name='data')

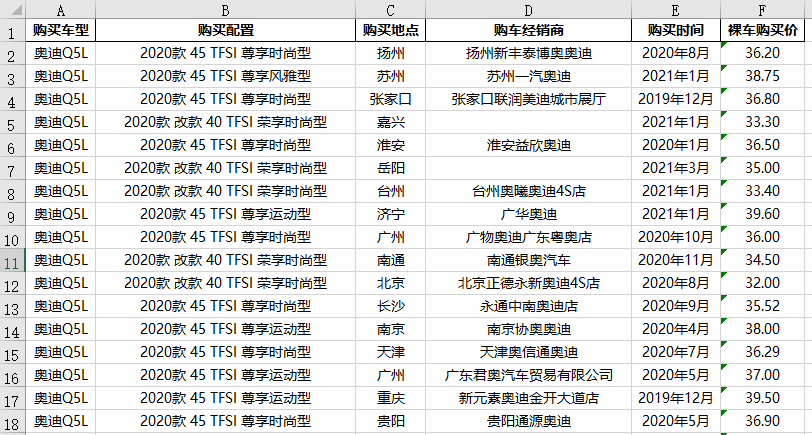

五、采集結果預覽

整個爬蟲過程比較簡單,采集下來的數據也比較規范,以本文案例奧迪Q5L示例如下:

到此這篇關於Python爬蟲之自動采集某車之傢各車銷售數據的文章就介紹到這瞭,更多相關Python采集汽車銷售數據內容請搜索WalkonNet以前的文章或繼續瀏覽下面的相關文章希望大傢以後多多支持WalkonNet!

推薦閱讀:

- 基於Python獲取亞馬遜的評論信息的處理

- 用Python爬取2022春節檔電影信息

- python使用xpath獲取頁面元素的使用

- Python用requests模塊實現動態網頁爬蟲

- Python爬蟲實戰之虎牙視頻爬取附源碼